Мечта о универсальном домашнем помощнике, том самом гуманоидном роботе из фантастики, который по первой же просьбе сложит белье или разберет покупки, долгое время оставалась лишь предметом нашего воображения. Однако 25 сентября лаборатория искусственного интеллекта Google DeepMind совершила настоящий прорыв, представив миру человекоподобного робота Apptronik Apollo, который, кажется, вплотную приблизился к воплощению этой мечты. В своем блоге компания опубликовала серию впечатляющих видео, где робот ловко управляется со складыванием одежды, сортировкой предметов по корзинам и даже аккуратно помещает вещи в сумку человека. Все эти действия он выполняет, понимая команды, отданные на простом естественном языке.

Эта демонстрация была призвана показать возможности новых моделей искусственного интеллекта компании — Gemini Robotics 1.5 и Gemini Robotics-ER 1.5. Как заявили в Google DeepMind, цель заключалась в том, чтобы проиллюстрировать, как большие языковые модели могут наделить физических роботов способностью воспринимать окружающий мир, планировать свои действия и выполнять сложные, многоэтапные задачи. Однако, как советует профессор электротехники и вычислительной техники Северо-Восточного университета Равиндер Дахия, к подобным заявлениям, особенно касающимся способности роботов «мыслить», стоит относиться с определенной долей здорового скептицизма.

Так в чем же реальная суть этой технологии. Обе модели, Gemini Robotics 1.5 и Gemini Robotics-ER 1.5, относятся к так называемым моделям действий на основе визуального языка. Как объясняет профессор Дахия, это означает, что для анализа внешнего мира они в основном опираются на данные с визуальных датчиков, а также на огромные массивы изображений и текстовой информации. Если говорить упрощенно, Gemini Robotics 1.5 работает как переводчик, преобразующий то, что видит робот, и голосовые инструкции в конкретные моторные команды для своих приводов. В то же время его «коллега», Gemini Robotics-ER 1.5, специализируется на изучении физических пространств, планировании маршрутов и принятии логистических решений в пределах своей среды.

Хотя со стороны это может выглядеть как магия, на деле вся эта сложная деятельность основана на четко определенном наборе правил и алгоритмов. Робот не мыслит самостоятельно в человеческом понимании этого слова. Его действия стали возможны благодаря колоссальным объемам высококачественных обучающих данных и тщательно структурированному планированию сценариев, подчеркивает Дахия. «В этом случае становится легко выполнять итерацию визуальных и языковых моделей, поскольку имеется большой объем данных, — говорит он. — компьютерное зрение в ИИ не является чем-то новым, оно существует уже давно». По-настоящему инновационным стало то, что команде DeepMind удалось успешно интегрировать эту технологию с большими языковыми моделями, позволив пользователям ставить задачи роботу, используя простую речь.

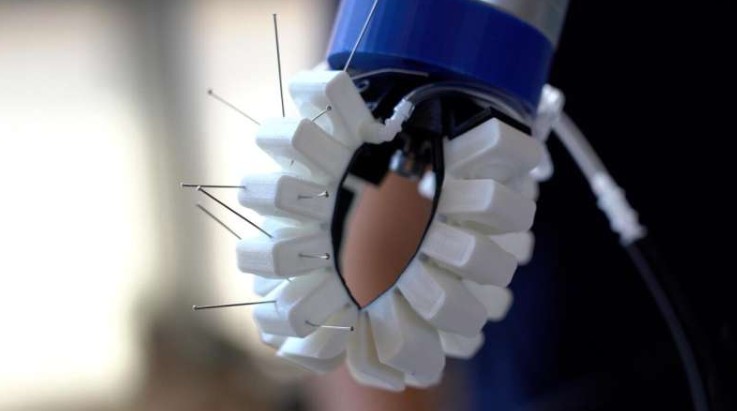

Безусловно, это впечатляющее достижение и шаг в правильном направлении, признает Дахия, однако до создания гуманоидных роботов, чьи сенсорные или мыслительные способности будут хоть сколько-нибудь сопоставимы с человеческими, нам еще очень далеко. К примеру, сам профессор Дахия и многие его коллеги по всему миру активно работают над разработкой технологий, которые позволили бы роботам не только видеть, но и чувствовать прикосновение, получая тактильную обратную связь. В частности, Дахия занимается созданием специальных электронных оболочек для роботов. Он акцентирует внимание на том, что, в отличие от данных для компьютерного зрения, обучающих данных для такого типа восприятия сегодня катастрофически не хватает, а это критически важно для манипуляций с хрупкими, мягкими или твердыми объектами.

Тактильное восприятие — это лишь один пример. Как отмечает исследователь, предстоит пройти огромный путь, чтобы наделить машины способностью распознавать боль, запахи или другие сложные сенсорные стимулы. «В условиях неопределенности вам нужно полагаться на все сенсорные возможности, а не только на зрение», — резюмирует профессор Дахия. Таким образом, несмотря на фантастический прогресс, демонстрируемый такими компаниями, как Google DeepMind, робот, который будет видеть, слышать, чувствовать и самостоятельно мыслить как человек, пока остается целью будущего, к которой научное сообщество продолжает упорно идти.